EU AI Act 2024

- Fabio Bonolo

- 7. Aug. 2024

- 13 Min. Lesezeit

Aktualisiert: 4. Juni 2025

Wie der M365 Copilot und ChatGPT abschneiden

Am 13. Juni 2024 wurde der neue AI Act der Europäischen Union veröffentlicht und tritt per 1. August 2024 in Kraft. Diese neue Gesetzgebung adressiert sowohl die Entwickler dieser KI-Lösungen (also Microsoft, OpenAI und Co.), als auch Unternehmen, die mit Copilot oder ChatGPT arbeiten (wollen). Der AI Act hat Anforderungen an Sicherheit, Transparenz und ethische Nutzung von Künstlicher Intelligenz gesetzlich verankert. Und sowieso ist das Thema Datenschutz seit dem Aufkommen von KI im Arbeitsumfeld extrem präsent. 💡

Da dieser Artikel sehr umfassend ist, fasse ich die wichtigsten Punkte gleich zu Beginn zusammen, bevor ich in die inhaltliche Tiefe abtauchen. Für jene von euch, die sich schnell einen Überblick verschaffen wollen. 😉

Summary

In diesem Blogbeitrag schauen wir die Auswirkungen des EU AI Act 2024 auf die zwei gängigsten KI-Lösungen, den M365 Copilot sowie ChatGPT, genauer an. Konkret habe ich die 20 wichtigsten Bestimmungen des Gesetzes erläutert und bewertet, inwieweit Copilot und ChatGPT diese Anforderungen erfüllen. ✔️

Zusammenfassend lässt sich sagen, dass beide KIs schon heute grundsätzlich gut mit den neuen Regularien übereinstimmen. Jedoch schneidet Copilot in vielen kritischen Punkten besser ab als ChatGPT und ist grundsätzlich sicherer zu nutzen. Ich habe schon so oft gehört, dass ChatGPT bessere Responses als Copilot liefert – und genau hier liegt der Hund begraben: Copilot kommt viel «robuster» oder «schwerfälliger» daher, weil es eben stark mit Regulationen und Einschränkungen bepackt ist, die dem EU AI Act entsprechen. Das geht halt (leider) auf Kosten der Performance, wobei ich sagen muss, dass Microsoft sehr grosse Fortschritte in den letzten Wochen und Monaten erzielt hat. 📈

Ein wichtiger Aspekt des neuen EU AI Acts gilt für alle Unternehmen, die auf OpenSource oder «Bring Your Own AI» (BYOAI) Modelle setzen. Mit diesen neuen Beschlüssen gilt es, diese KI-Modelle genaustens auf die vorhandenen Resolutionen zu prüfen, sodass man Bussen oder weiteren Konsequenzen aus dem Weg gehen kann. 🔍

Bevor wir in die Tiefen dieses Artikels eintauchen, habe ich für euch eine Bewertungstabelle erstellt, welche den Funktionsumfang von Copilot und ChatGPT in Bezug auf die angesprochenen 20 Resolutionen auf einfache Art und Weise gegenüberstellt. ⬇️

Detailanalyse

Tauchen wir nun also ein in die einzelnen Resolutionen, welche ich grob umreisse und dann mit Copilot und ChatGPT gegenüberstelle, um die beiden KIs auf die Anforderungserfüllung bewerten zu können. 🛫

1. Risikobasierte Klassifizierung von KI-Systemen

Diese Resolution fordert eine risikobasierte Klassifizierung von KI-Lösungen. Die Kategorien sind: Minimales Risiko; Begrenztes Risiko; Hohes Risiko; Unannehmbares Risiko. Je höher das Risiko, desto strenger werden die Anforderungen an Sicherheit und Überwachung, während KI-Lösungen mit minimalem Risiko weniger strengen Auflagen unterliegen.

🧑🏻✈️ Copilot: Copilot for Microsoft 365 ist als Werkzeug zur Produktivitätssteigerung und Unterstützung in der täglichen Arbeit klassifiziert und fällt in die Kategorie Begrenztes Risiko. Dies aufgrund der bereits im Standard vorhandenen Datenschutz-, Privatsphäre und Sicherheitseinstellungen. Entsprechend hat es keine allzu strengen Anforderungen.

🤖 ChatGPT: ChatGPT kann je nach Anwendungsfall in unterschiedliche Risikokategorien fallen. Grundsätzlich fällt ChatGPT ebenfalls in die Kategorie Begrenztes Risiko. Wenn ChatGPT jedoch in sensiblen oder kritischen Bereichen eingesetzt wird, wie z.B. in der medizinischen Beratung, oder als Entscheidungsinstrument in juristischen oder finanziellen Kontexten, würde es in die Kategorie Hohes Risiko eingestuft werden, da ChatGPT nicht dieselben strengen Sicherheitsregeln wie Copilot mitbringt.

Bewertung: Copilot = 😊 ChatGPT = 😐

2. Transparenz und Informationspflichten

Der EU AI Act verlangt, dass KI-Lösungen transparent sind und die Endanwender über deren Funktionsweise informiert werden. Dazu gehört auch, dass KI-generierte Inhalte wie Texte, Bilder oder Videos auch als solche gekennzeichnet werden. Ausserdem sind Anbieter dazu verpflichtet, Informationen wie eine Zusammenfassung von urheberrechtlich geschützten Daten, die für das LLM-Training verwendet wurden, veröffentlichen zu müssen. Entsprechend sollen Endanwender umfänglich über den Einsatz der KI informiert sein.

🧑🏻✈️ Copilot: In der Anwendung von Copilot for Microsoft 365 gibt es immer Hinweise und Links über die Nutzung. Ausserdem hat Microsoft sehr viele Informationen und Lernunterlagen zu Copilot veröffentlicht und für alle zugänglich gemacht.

🤖 ChatGPT: In ChatGPT ist gut ersichtlich, dass es sich um ein KI-System handelt, doch die Erklärung der Funktionsweise und der Datenmodelle lässt noch zu wünschen übrig. OpenAI hat aber bereits mehrfach angekündigt (zuletzt beim Release von GPT-4o) die Transparenz und auch den Datenschutz verbessern zu wollen. Geschehen ist bisher aber nicht viel.

Bewertung: Copilot = 😊 ChatGPT = 🙁

3. Menschliche Aufsicht

Der EU AI Act betont die Notwendigkeit menschlicher Aufsicht über KI-Systeme, um sicherzustellen, dass diese im Sinne der Anwender agieren und ethische Grundsätze einhalten. Menschen müssen in der Lage sein, KI-Prozesse zu überwachen und bei Bedarf einzugreifen.

🧑🏻✈️ Copilot: Copilot for Microsoft 365 ermöglicht es jederzeit während des Generierungsprozesses manuell einzugreifen. Auch durch das Copilot Dashboard und weitere Einstellungen über das Admin Center ist die menschliche Aufsicht gewährleistet.

🤖 ChatGPT: Auch in ChatGPT kann die Generierung unterbrochen werden, jedoch fehlt ein Aufsichtsmechanismus. OpenAI hat zwar Moderationstools entwickelt, aber eine vollständige Kontrolle durch den Nutzer oder Admins ist nicht immer gegeben.

Bewertung: Copilot = 😊 ChatGPT = 😐

4. Datensicherheit und Datenschutz

KI-Lösungen müssen strenge Datenschutzrichtlinien einhalten und sicherstellen, dass insbesondere personenbezogene Daten geschützt sind. Das heisst es müssen Massnahmen her, die den unbefugten Zugriff sowie die Einsicht von sensiblen Daten verhindern.

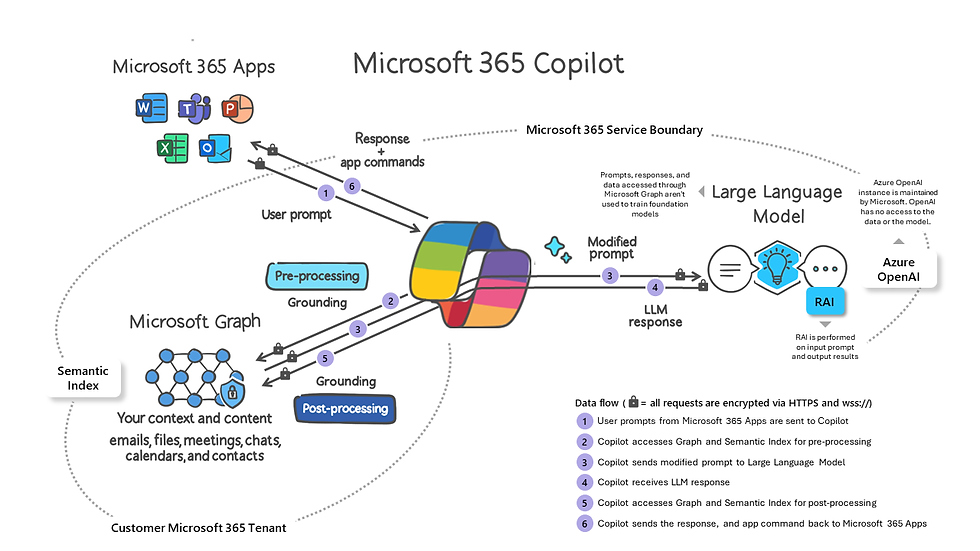

🧑🏻✈️ Copilot: Hier ist Microsoft extrem stark aufgestellt. Einerseits ist das KI-Modell so aufgebaut, dass Prompts und Informationen innerhalb des Tenants bleiben und nicht an Microsoft geht, andererseits erbt Copilot die Rechte eines jeden einzelnen Nutzers. Zudem gibt es schon vor der KI-Zeit Compliance-Lösungen wie Sensitivity Labels oder Data Loss Prevention Policies (DLP), die sämtliche M365-Daten zusätzlich und spezifisch schützen.

🤖 ChatGPT: OpenAI bemüht sich zwar um die Einhaltung der Datenschutzrichtlinien, dennoch sind die implementierten Sicherheitsmassnahmen kein Vergleich mit Copilot. Sämtliche Daten, die in ChatGPT eingegeben werden (insbesondere bei der Gratis-Version) gehen uneingeschränkt zu OpenAI und öffnet dadurch einige Risiken in Bezug auf den Datenschutz.

Bewertung: Copilot = 😊 ChatGPT = 🙁

5. Bias- und Diskriminierungsfreiheit

Massnahmen zur Vermeidung von Diskriminierung und Verzerrungen ist ebenfalls eine Resolution aus dem EU AI Act. Entsprechende Massnahmen sollen sicherstellen, dass KI-Lösungen fair und unvoreingenommen arbeiten.

🧑🏻✈️ Copilot: Microsoft hat in Copilot umfangreiche Mechanismen integriert, um Bias zu identifizieren und zu minimieren, einschliesslich der regelmässigen Überprüfung und Anpassung der Algorithmen. Das LLM wird spezifisch darauf trainiert, neutrale Antworten zu generieren.

🤖 ChatGPT: OpenAI arbeitet aktiv daran, Bias in ihren Modellen zu erkennen und zu minimieren. Dennoch ist ChatGPT nicht vollkommen frei von Verzerrungen und kann unbeabsichtigt voreingenommene Inhalte generieren.

Bewertung: Copilot = 😊 ChatGPT = 😐

6. Robustheit und Genauigkeit

Auf diesen Punkt muss ich etwas genauer eingehen, denn das ist eine echte Knacknuss! 😅 Ich versuch's mal mit einer Definition – Diese Bestimmung zielt darauf ab, sicherzustellen, dass KI-Systeme zuverlässige und präzise Ergebnisse liefern und in der Lage sind, mit Unsicherheiten und potenziellen Störungen umzugehen. – Robustheit bedeutet, dass die KI auch unter unerwarteten Bedingungen und Einflüssen stabil bleibt und keine Fehlfunktionen zeigt. Genauigkeit bezieht sich auf die Fähigkeit der KI, inhaltlich korrekte Ergebnisse zu generieren.

Die Schnelligkeit und Performance eines KI-Modells haben indirekt Einfluss auf seine Robustheit und Genauigkeit. Es ist wichtig zu verstehen, dass Schnelligkeit nicht auf Kosten der Genauigkeit gehen darf, denn die generierten Antworten müssen nicht nur schnell, sondern auch präzise sein.

Ein weiterer Aspekt der Robustheit ist die Fähigkeit der KI, mit fehlerhafter Grammatik umgehen zu können und diese Prompts so verarbeiten, dass es zu keinen erheblichen Leistungsabfällen kommt.

🧑🏻✈️ Copilot: Bei Copilot kann man sich ein wenig darüber streiten. Einerseits ist das Modell äusserst robust, zeigt jedoch (berechtigte) Schwächen bei der Genauigkeit und Schnelligkeit. Für richtig gute Ergebnisse müssen die Prompts schon äusserst präzise sein im Gegensatz zu ChatGPT, wo gute Ergebnisse leichter zu erreichen sind.

🤖 ChatGPT: ChatGPT ist insbesondere mit dem neuen GPT-4o Modell brutal performant, der Ausfall von vor ein paar Wochen zeigt aber, dass es in Puncto Robustheit möglicherweise noch nicht ganz ausgereift ist.

Bewertung: Copilot = 😐 ChatGPT = 😐

7. Sicherheitsmechanismen und Überwachung

Der EU AI Act verlangt von den Herstellern konkrete Sicherheitsmechanismen und kontinuierliche Überwachung ihrer KI-Modelle. Diese Massnahmen sollen sicherstellen, dass potenzielle Bedrohungen frühzeitig erkannt und behoben werden können.

🧑🏻✈️ Copilot: Copilot for Microsoft 365 verfügt über umfassende automatische Sicherheitskonfigurationen und wird fortlaufend überwacht – sowohl von Microsoft, als auch von den Admins des Unternehmen-eigenen Tenants – um potenzielle Sicherheitsbedrohungen frühzeitig zu erkennen und zu beheben.

🤖 ChatGPT: Auch OpenAI hat Sicherheitsmechanismen für ChatGPT implementiert und überwacht die Systeme kontinuierlich.

Bewertung: Copilot = 😊 ChatGPT = 😊

8. Nachvollziehbarkeit und Auditierbarkeit

Um die Einhaltung der rechtlichen Anforderungen zu entsprechen, müssen KIs nachverfolg- und auditierbar sein. Gerade wenn es um Audits geht, die in Konzernen und behördenrelevante Unternehmen regelmässig stattfinden, ist dies eine besonders wichtige Anforderung aus dem EU AI Act.

🧑🏻✈️ Copilot: Prompts werden in M365 gespeichert und auch die Analytics-Funktionen von Copilot können sich echt sehen lassen. Dafür gibt es die Audit-Logs in Microsoft Purview, die spezifisch auf die Nutzung von Copilot heruntergebrochen werden können.

🤖 ChatGPT: Hier liegt die Hoheit bei OpenAI. Prompts und Verläufe werden zwar gespeichert, die Nachvollziehbarkeit liegt aber nicht beim nutzenden Unternehmen. Ob dieser Umstand einem Audit standhalten würde, stelle ich jetzt mal in Frage.

Bewertung: Copilot = 😊 ChatGPT = 😐

9. Kontinuierliche Verbesserung

Der EU AI Act betont die Notwendigkeit kontinuierlicher Verbesserungen von KI-Modellen. Unternehmen müssen sicherstellen, dass ihre eingesetzten KI-Lösungen regelmässig aktualisiert und verbessert werden.

🧑🏻✈️ Copilot: Microsoft stellt sicher, dass Copilot for Microsoft 365 regelmässig aktualisiert und verbessert wird. Einerseits ist der Hyperscaler technologisch sehr innovativ und andererseits kann Microsoft auf eine starke Community zurückgreifen, die regelmässiges Feedback zu Produktverbesserungen einbringt.

🤖 ChatGPT: Auch OpenAI gehört zu den Innovatoren auf dem Markt und hat mit ChatGPT den Durchbruch von KI im Arbeitsumfeld erst ermöglicht! Auch die regelmässige Veröffentlichung von neuen GPT-Modellen spricht für sich.

Bewertung: Copilot = 😊 ChatGPT = 😊

10. Ethik- und Verhaltenskodex

Diese Bestimmung zielt darauf ab, dass sowohl Hersteller von KI-Technologien als auch Unternehmen, die diese Künstliche Intelligenzen nutzen, klare ethische Richtlinien und Verhaltensstandards einhalten. Der Ethik- und Verhaltenskodex sollte sicherstellen, dass die KI verantwortungsvoll, fair und im Einklang mit grundlegenden Werten der Gesellschaft eingesetzt werden.

🧑🏻✈️ Copilot: Microsoft hat einen umfassenden Ethik- und Verhaltenskodex etabliert, der die Nutzung von KI-Systemen wie Copilot for Microsoft 365 regelt und sicherstellt, dass ethische Grundsätze eingehalten werden.

🤖 ChatGPT: OpenAI hat ebenfalls ethische Leitlinien implementiert, um die verantwortungsvolle Nutzung von ChatGPT sicherzustellen. Diese Leitlinien sind öffentlich zugänglich und werden regelmässig überprüft und aktualisiert.

Bewertung: Copilot = 😊 ChatGPT = 😊

11. Benutzerfreundlichkeit

Der EU AI Act fordert, dass KI-Systeme benutzerfreundlich und intuitiv gestaltet sind. Dies umfasst eine einfache Bedienbarkeit und eine klare Benutzeroberfläche, die die Interaktion mit der KI erleichtert.

🧑🏻✈️ Copilot: Durch die Integration in M365, die vorgeschlagenen Prompts sowie das Prompt-Lab nimmt Copilot eine absolute Vorreiterrolle in Puncto Benutzerfreundlichkeit ein. Aus meiner Sicht Bestnote mit Sternchen!

🤖 ChatGPT: Auch ChatGPT ist benutzerfreundlich designt und ermöglicht es auf natürliche Weise mit dem Tool zu interagieren.

Bewertung: Copilot = 😊 ChatGPT = 😊

12. Schulung und Sensibilisierung

Auch der EU AI Act anerkennt die Wichtigkeit von Schulungen und Wissensaufbau. In dieser Resolution wird festgelegt, dass Mitarbeitende ausreichend über die Nutzung von KI geschult und sensibilisiert werden müssen, um das Verständnis und die Akzeptanz von KI-Technologien zu fördern.

🧑🏻✈️ Copilot: Microsoft bietet umfangreiche Schulungs- und Sensibilisierungsprogramme an, die den Nutzern helfen, Copilot for Microsoft 365 effektiv zu nutzen und die Funktionsweise des Systems zu verstehen. Auch Grosskunden und Partner werden von Microsoft (finanziell) für die Durchführung von Trainings und Workshops unterstützt.

🤖 ChatGPT: OpenAI bietet ebenfalls Ressourcen zur Schulung und Sensibilisierung an, jedoch könnten aus meiner Sicht die Programme weiter ausgebaut werden, um eine stärkere Benutzeraufklärung und Schulung zu gewährleisten.

Bewertung: Copilot = 😊 ChatGPT = 😐

13. Haftung und Verantwortlichkeit

Auch auf diesen Punkt muss ich genauer eingehen, da man diesen schnell missverstehen kann. Der EU AI Act 2024 legt fest, dass klare Haftungs- und Verantwortlichkeitsstrukturen sowohl für den Einsatz als auch für die Entwicklung von KI-Lösungen bestehen müssen. Dies bedeutet, dass sowohl die Entwickler von KI-Modellen als auch die Unternehmen, die diese Technologien einsetzen, klare Verantwortlichkeiten tragen und haftbar gemacht werden können, wenn die Systeme Schaden verursachen oder gegen gesetzliche Vorschriften verstossen.

Kernaspekte der Bestimmung:

Haftung der Entwickler

Unternehmen, die KI-Systeme entwickeln, also z.B. Microsoft und OpenAI, sind verantwortlich für die Sicherheit und Zuverlässigkeit ihrer Produkte. Sie müssen sicherstellen, dass ihre Modelle den gesetzlichen Anforderungen entsprechen, sicher und zuverlässig funktionieren und keine Schäden verursachen. Wenn ein Fehler oder ein Mangel in der Entwicklung oder im Betrieb einer KI zu Schäden führt, können die Entwickler haftbar gemacht werden.

Haftung der Anwender/Unternehmenskunden

Unternehmen, die KI-Lösungen einsetzen, tragen ebenfalls eine Verantwortung dafür, dass diese Systeme korrekt und im Einklang mit den gesetzlichen Bestimmungen verwendet werden. Dies umfasst die ordnungsgemässe Implementierung, Überwachung und Wartung sowie die Schulung der Mitarbeiter im Umgang mit der KI. Wenn ein Unternehmen eine KI-Technologie unsachgemäss verwendet oder die nötigen Sorgfaltsmassnahmen unterlässt, kann es ebenfalls haftbar gemacht werden.

🧑🏻✈️ Copilot: Microsoft übernimmt Verantwortung für die Sicherheit und Zuverlässigkeit von Copilot und stellt umfassende Informationen und Support für die Anwender bereit. Das Stichwort hier lautet «ResponsibleAI». Unternehmen, die Copilot einsetzen, profitieren darüberhinaus von regelmässigen Updates und Sicherheitsüberprüfungen.

🤖ChatGPT: OpenAI übernimmt ebenfalls Verantwortung für die Entwicklung von ChatGPT und stellt Ressourcen zur Verfügung, um die sichere und effektive Nutzung zu unterstützen. Allerdings bildet die nicht regulierte Nutzung ein Risiko dar, was die Einhaltung aller Vorschriften angeht. Entsprechend offener ist die Haftungsfrage in diesem Fall.

Bewertung: Copilot = 😊 ChatGPT = 😐

14. Regulatorische Berichterstattung

Unternehmen müssen regelmässig Berichte über die Nutzung und den Einsatz ihrer KI-Lösungen vorlegen. Diese Berichte sollen die Einhaltung gesetzlicher Vorgaben und die Transparenz des Einsatzes von Künstlicher Intelligenz sicherstellen.

🧑🏻✈️ Copilot: Microsoft stellt sicher, dass regelmässige Berichte über die Nutzung von Copilot for Microsoft 365 erstellt werden. Da gehört beispielsweise der Microsoft Work Trend Index dazu. Diese Berichte werden auch den entsprechenden Regulierungsbehörden zur Verfügung gestellt.

🤖 ChatGPT: Auch OpenAI veröffentlicht regelmässig Berichte und wissenschaftliche Arbeiten über die Entwicklungen und die Nutzung von ChatGPT und stellt diese uneingeschränkt zur Verfügung.

Bewertung: Copilot = 😊 ChatGPT = 😊

15. Zusammenarbeit mit Aufsichtsbehörden

Auch fordert die EU eine enge Zusammenarbeit zwischen KI-Anbietern und den zuständigen Aufsichtsbehörden. Diese Bestimmung soll sicherstellen, dass KI-Technologien kontinuierlich überwacht werden und den geltenden gesetzlichen Vorschriften entsprechen. Die Zusammenarbeit mit den Aufsichtsbehörden ist entscheidend, um Transparenz zu gewährleisten, die Einhaltung von Vorschriften sicherzustellen und eventuelle Risiken oder Probleme frühzeitig zu erkennen und zu beheben.

🧑🏻✈️ Copilot: Microsoft ist bekannt dafür mit Government-Entities zusammenzuarbeiten – es gibt spezifische Behörden-Lizenzen sogar Feature-Rollouts, die nur für öffentliche Institutionen bestimmt sind.

🤖 ChatGPT: OpenAI arbeitet ebenfalls eng mit Aufsichtsbehörden zusammen und stellt technische Informationen sowie Berichte über die Nutzung und Sicherheit von ChatGPT bereit. Die einzige Einschränkung, die ich als «Externer» in Betracht ziehen muss, ist die mangelnde Transparenz für die Nutzer. Hier muss ich auf das «Wort» von OpenAI vertrauen. Trotzdem empfinde ich das nicht als punkteabzugwürdig.

Bewertung: Copilot = 😊 ChatGPT = 😊

16. Transparenz der Generierungsprozesse und Algorithmen

Eine weitere Bestimmung der neuen Gesetzgebung ist, dass Anbieter von KI-Modellen transparent darlegen können, wie der Prozess der generierten Antworten ist. Das heisst die Algorithmen und Datenquellen, welche für die Generierung der Antworten herbeigezogen werden, sollen für den Nutzer transparent ersichtlich gemacht werden.

🧑🏻✈️ Copilot: Hier punktet Copilot besonders gut, da es nämlich gleich zwei Aspekte gibt: Einerseits legte Microsoft von Anfang an den Generierungsprozess offen und fügt zu jeder generierten Antwort entsprechende Datenquellen hinzu (man denke da an die kleinen Zahlen im Text und die unterstrichenen Textbereiche).

🤖 ChatGPT: Demgegenüber macht ChatGPT keine so gute Falle. Die Datenquellen werden üblicherweise nicht angegeben und auch der Generierungsprozess ist nicht offengelegt.

Bewertung: Copilot = 😊 ChatGPT = 🙁

17. Meldung von Zwischenfällen

Der EU AI Act verlangt die sofortige Meldung von Zwischenfällen, die durch KI verursacht werden. Konkret muss ein Mechanismus zur Meldung von Vorfällen und Problemen vorhanden sein. Dies bedeutet, dass Nutzer in der Lage sein müssen, Probleme schnell und einfach zu melden, damit diese zeitnah behoben werden können.

🧑🏻✈️ Copilot: Microsoft Purview, Defender, Sentinel… durch die Integration von Copilot in M365 greift übernimmt Copilot die standardmässigen Meldefunktionen und ist daher bestens für diese Resolution ausgerüstet.

🤖 ChatGPT: Auch OpenAI hat ein kontinuierliches Monitoring und Alerting für ChatGPT implementiert und bietet auch benutzerfreundliche Meldewege von Vorfällen.

Bewertung: Copilot = 😊 ChatGPT = 😊

18. Internationale Zusammenarbeit

Mit dem EU AI Act soll die internationale Zusammenarbeit bei der Regulierung und Überwachung von KI-Technologien gefördert werden. Dazu gehört auch die Zusammenarbeit zwischen KI-Entwicklern und der Forschungsgemeinschaft. Dies bedeutet, dass die Entwickler von KI-Systemen eng mit Forschungseinrichtungen zusammenarbeiten müssen, um die KI-Modelle kontinuierlich zu verbessern. Auch die Förderung von Innovation vonseiten der nationalen Behörden gehört in diese Kategorie.

🧑🏻✈️ Copilot: Microsoft engagiert sich in internationalen Kooperationen sowohl mit Behörden als auch mit Forschungsinstitutionen um ihre Technologien (nicht nur KI) auf dem neuesten Stand zu halten.

🤖 ChatGPT: OpenAI beteiligt sich ebenfalls aktiv an der internationalen Zusammenarbeit und arbeitet mit globalen Institutionen zusammen, um die Entwicklung und Einhaltung von KI-Standards zu fördern.

Bewertung: Copilot = 😊 ChatGPT = 😊

19. Soziale Verantwortung

Anbieter von Künstlicher Intelligenz sind einer sozialen Verantwortung unterzogen. Diese Bestimmung stellt sicher, dass KI-Technologien nicht nur wirtschaftlich erfolgreich, sondern auch sozial gerecht und inklusiv sind. Dazu gehört beispielsweise die barrierefreie Gestaltung der KI-Lösung.

🧑🏻✈️ Copilot: Microsoft setzt sich in umfangreichem Masse für Inklusion und Barrierefreiheit ein. Auch der M365 Copilot ist mit vielen barrierefreien Funktionen ausgestattet.

🤖 ChatGPT: Auch OpenAI engagiert sich für die soziale Verantwortung und entwickelt ChatGPT mit dem Ziel, der Gesellschaft positive Dienste zu leisten und barrierefrei zu gestalten.

Bewertung: Copilot = 😊 ChatGPT = 😊

20. Nachhaltigkeit

Darüber hinaus möchte die EU auch eine ökologisch nachhaltige Nutzung von Künstlicher Intelligenz sicherstellen. Diese Resolution umfasst umweltfreundliche Entwicklungs- und Betriebspraktiken sowie die Minimierung des ökologischen Fussabdrucks von KI-Technologien.

🧑🏻✈️ Copilot: Microsoft hat sich klare Nachhaltigkeitsziele gesetzt und kommuniziert. Mit der aktuellen Umrüstung ihrer Rechencenter zahlen sie auch voll auf diese Ziele ein.

🤖 ChatGPT: OpenAI verfolgt nachhaltige Praktiken in der Entwicklung und dem Betrieb von ChatGPT. Doch die hohen Rechenressourcen, die für das Training und den Betrieb ihres LLM erforderlich sind, stellen eine Herausforderung für die Nachhaltigkeit dar.

Bewertung: Copilot = 😊 ChatGPT = 😐

Schlussfolgerung

Copilot for Microsoft 365 und ChatGPT von OpenAI zeigen beide ein starkes Engagement für die Einhaltung der Bestimmungen des EU AI Act 2024. Microsoft und OpenAI haben umfassende Massnahmen implementiert, um Sicherheit, Transparenz und ethische Grundsätze zu gewährleisten. Für mich ist Copilot jedoch der absolut klare Gewinner, da es schon heute so ziemlich alle Bestimmungen erfüllt oder gar übertrifft. 👏🏼

Microsoft setzt einen hohen Standard in der Einhaltung der neuen regulatorischen Anforderungen. Durch die Integration in M365 werden die hohen Sicherheits- und Compliance-Lösungen automatisch für Copilot übernommen und decken damit sämtliche Anforderungen des EU AI Acts ab. ✨

OpenAI zeigt ebenfalls ein starkes Engagement für die Einhaltung der Bestimmungen und bringt innovative Ansätze zur kontinuierlichen Verbesserung und punktet insbesondere mit der Performance. Doch es liegen klare Schwächen in der Einhaltung des Datenschutzes und Sicherheitsbestimmungen vor. ☝🏼

Ich persönlich habe noch den aktuellen Microsoft Work Trend Index im Hinterkopf. Dieser besagt, dass «Bring Your Own AI» (BYOAI) - also das Modell, dass Mitarbeitende ihre präferierte KI-Lösung nutzen können - in Unternehmen stark an Bedeutung zunimmt. Mit dem neuen EU AI Act rückt dieses Modell in ein ganz anderes Licht. Sowohl Konzerne als auch KMUs, welche dieses Modell fördern, müssen aufgrund der neuen Gesetzgebung definitiv über die Bücher.

Insgesamt bieten beide GenAIs wertvolle Dienste und zeigen, wie führende Technologieunternehmen auf die Herausforderungen des neuen KI-Gesetzes für Europa reagieren können. 🚀

Kommentare